Viele von uns haben es schon einmal erlebt, dass künstliche Intelligenz eine Antwort geliefert hat, die unwahr war – sogenannte KI-Halluzinationen. Gerade wenn es um sensible Daten wie Unternehmensdaten geht kann das das schmerzen oder sogar gefährlich werden. In diesem Artikel zeigen wir, wie KI-Halluzinationen passieren, und was wir gegen sie machen können.

Was sind KI-Halluzinationen?

KI-Halluzinationen treten auf, wenn Künstliche Intelligenzen, insbesondere Sprachmodelle, falsche oder irreführende Informationen erzeugen, die wie plausible Antworten erscheinen. Diese Phänomene resultieren aus der KI-Fähigkeit, Muster zu erkennen und Vorhersagen zu treffen, jedoch ohne tatsächliches Verständnis oder Faktenwissen. Dies kann dazu führen, dass die KI erfundene Details liefert, die nicht auf realen Daten basieren.

Was sind Gründe für KI-Halluzinationen?

Die Gründe für KI-Halluzinationen liegen meistens in unzureichenden Trainingsdaten, technischen Problemen bei der Datenverarbeitung oder bei Interpretationsfehlern.

Unzureichende oder veraltete Trainingsdaten

Die KI wurde möglicherweise mit historischen Daten trainiert, die Bonn als provisorische Hauptstadt der Bundesrepublik Deutschland während der Teilung Deutschlands (1949–1990) beinhalten. Wenn die KI diese Daten nicht korrekt mit aktuellen Informationen abgleicht, könnte sie fälschlicherweise annehmen, dass Bonn immer noch die Hauptstadt ist.

Technische Probleme bei der Datenverarbeitung

Bei der Verarbeitung der Anfrage könnte ein technisches Problem auftreten, das dazu führt, dass die KI auf veraltete oder unvollständige Informationen zugreift. Dies kann passieren, wenn die Datenbank, auf die die KI zugreift, nicht aktualisiert wurde oder wenn es Fehler im Datenabgleich gibt.

Bias im Trainingsmaterial

Wenn das Trainingsmaterial der KI eine Verzerrung aufweist und überproportional viele Referenzen zu Bonn als Hauptstadt enthält, könnte die KI diese Verzerrung übernehmen und fälschlicherweise Bonn als Hauptstadt angeben.

Interpretationsfehler

Die KI könnte die Anfrage falsch interpretieren, insbesondere wenn sie mehrdeutig formuliert ist. Beispielsweise könnte eine unklare Formulierung dazu führen, dass die KI historische und aktuelle Informationen vermischt.

Gibt es KI Halluzinationen Beispiele?

Nehmen wir an, eine Person fragt die KI: „Was ist die Hauptstadt von Deutschland?“ und die KI antwortet mit einer Halluzination: „Bonn ist die Hauptstadt von Deutschland.“

So kann diese KI-Halluzination entstehen:

- Historischer Kontext: Die KI hat möglicherweise Zugang zu historischen Informationen, die Bonn als provisorische Hauptstadt der BRD beschreiben.

- Datenzugriffsproblem: Die KI hat möglicherweise keine aktuellen Daten oder greift auf eine veraltete Datenbank zu.

- Bias: Das Trainingsmaterial enthält möglicherweise eine übermäßige Menge an Informationen über Bonn als Hauptstadt und nicht genug aktuelle Informationen über Berlin.

KI-Halluzinationen wie diese zeigen, dass Künstliche Intelligenz nicht unfehlbar ist und dass die Qualität und Aktualität der Daten, mit denen sie trainiert und betrieben wird, von entscheidender Bedeutung sind. Sie verdeutlichen auch die Notwendigkeit einer sorgfältigen Überprüfung und Korrektur von KI-generierten Informationen durch Menschen.

Welche Lösungen gibt es gegen KI-Halluzinationen?

💡 Bedeutet das jetzt, dass wir KI nicht vertrauen können und in der Konsequenz nicht verwenden sollten? Nein! Es gibt Wege, diese sogenannten KI-Halluzination zu unterdrücken und wirklich vertrauenswürdige Antworten zu erhalten.

Ein großer Hebel liegt in der Datenbank: saubere, aktuelle und relevante Daten erhöhen die Wahrscheinlichkeit, dass die KI valide und relevante Informationen findet und verarbeiten kann.

KI-Halluzinationen können aber auch technisch unterdrückt werden. Mit unterschiedlichen Tests können Antworten bzw. Antwortteile überprüft werden, beispielsweise auf Nützlichkeit, Relevanz und Validität.

Wie lassen sich KI-Halluzinationen technisch unterdrücken?

Um die Genauigkeit und Zuverlässigkeit von großen Sprachmodellen (LLMs) zu gewährleisten, ist es entscheidend, die Daten korrekt zu verarbeiten und zu strukturieren. Hier sind einige bewährte Methoden, um KI-Halluzinationen zu vermeiden:

RAG-Systeme

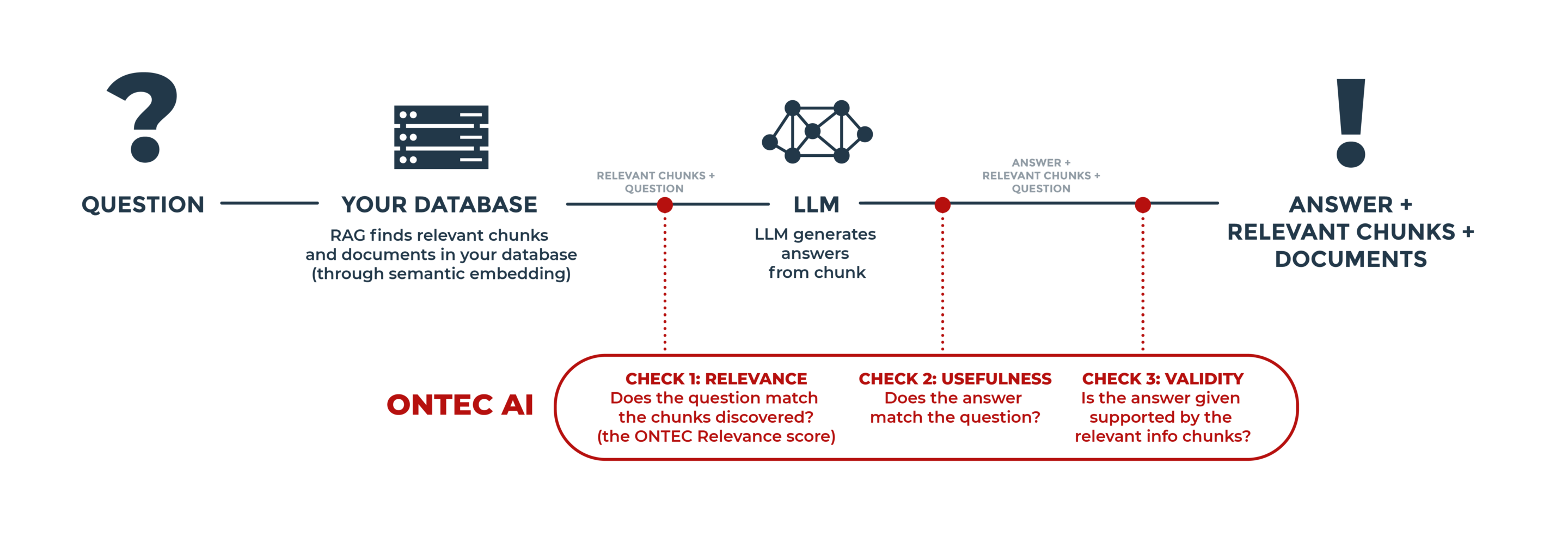

RAG steht für Retrieval Augmented Generation. Dabei wird die Datenbank auf Informationen zur Frage untersucht und daraus resultierende Antwortteile auf ihre Qualität überprüft, bevor die finale Antwort an den Nutzer ausgegeben wird.

Die folgende Grafik zeigt beispielsweise, mit welchen Maßnahmen unser eigenes RAG-System KI-Halluzinationen unterdrückt.

Daten richtig „übersetzen“

Damit LLMs die Daten effizient verarbeiten können, müssen diese in ein lesbares Format übersetzt werden. Ein Beispiel hierfür ist die Umwandlung von Tabellen in ein Format, das für das Modell verständlich ist. Dies stellt sicher, dass die Informationen korrekt interpretiert und genutzt werden.

Daten sinnvoll chunken

Dokumente sollten in kleinere, handhabbare Teile (Chunks) zerlegt werden. Diese Chunks müssen intelligent und kontextbezogen angenommen werden, wie etwa Absätze oder spezifische Abschnitte in mehrseitigen Tabellen. Ein Beispiel hierfür ist die korrekte Segmentierung von Tabellen, die Informationen über nicht bezahlte Anwendungen enthalten.

Daten effizient durchsuchen

Eine effiziente Suche ist entscheidend, um relevante Informationen schnell und präzise zu finden.

ONTEC AI nutzt beispielsweise eine hybride Suchstrategie, die sowohl semantische als auch stichwortbasierte Ansätze kombiniert. Dies bedeutet, dass Begriffe wie „datenschutzverantwortlicher“ und „Datenschutzbeauftragter“ semantisch gleichgesetzt werden, während spezielle Wörter wie „Zytostatika“ gezielt erkannt und verarbeitet werden.

Durch die Anwendung dieser Strategien können KI-Halluzinationen minimiert und die Leistung von LLMs erheblich verbessert werden.

Webinar: Halluzination oder Realität?

Christian Casari, Head of Sales bei ONTEC AI.

Alexander Göppel, Sales Executive bei Aleph Alpha.

Die genaue Erklärung zusammen mit vielen Details und Beispielen aus der Praxis gibt es im Webinar:

- Die Relevanz von Halluzinationen

- Die Forschungs- und Entwicklungstätigkeiten von Aleph Alpha und ONTEC

- Beispiele aus der Praxis: Herausforderungen und Lösungen

- Der technische Hintergrund: LLM, RAG, Finetunig und andere Kernkonzepte

- Welche Entwicklung können wir in den nächsten Jahren erwarten?

Klingt spannend?

Gerne sprechen wir mit Ihnen über die Anforderungen Ihrer sensiblen Daten und wie sie diese verlässlich abfragen können.